强化学习3 :马尔可夫决策过程

在本文中,我们将通过一个简单的例子来解释机器学习这一经典概念。

到最后,您将掌握以下基本知识:

- 如何定义马尔可夫决策过程;

- MDP是如何工作的,一个简单的例子;

- 为什么以及如何使用折扣奖励。

为什么我们需要了解 MDP

要理解为什么 MDP 对 RL 如此重要,我们必须回顾强化学习,第 1 部分中定义的四个必要元素。这些是代理、环境、行动和奖励。如果您可以在 MDP 中构建您的任务,那么恭喜您!您已经定义了您的环境。 现在您有了一个空间,代理可以在其中采取行动、获得奖励和学习。

MDP 是一个可以用离散动作解决大多数强化学习问题的框架。借助马尔可夫决策过程,代理人可以得出最优策略(我们将在下周讨论)以随着时间的推移获得最大回报。

现在,为了实际理解其工作原理,让我们提出示例任务:今天,我们将帮助一个名叫亚当的年轻人做出连续决策,以赚取尽可能多的钱。

定义马尔可夫决策过程 (MDP)

阅读我的上一篇文章后,您应该对马尔可夫属性是什么以及我们使用马尔可夫链时的样子有一个很好的了解。这意味着我们已准备好深入研究 MDP 的基本强化学习概念。

回想一下我们对马尔可夫链的讨论,它与一组状态S和从一个状态转换到下一个状态的概率P一起工作。 它还使用Markov Property,这意味着每个状态仅取决于紧接在它之前的状态。

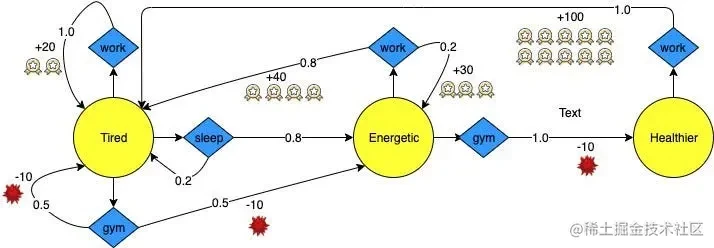

图 2:马尔可夫决策过程示例

现在,马尔可夫决策过程与马尔可夫链的不同之处在于它使行动发挥作用。这意味着下一个状态不仅与当前状态本身有关,而且与在当前状态下采取的操作有关。此外,在 MDP 中,一些对应于状态的动作可以返回奖励。

事实上,MDP 的目的是训练代理人找到一种策略,该策略将从在一个或多个状态下采取的一系列动作中返回最大的累积奖励。

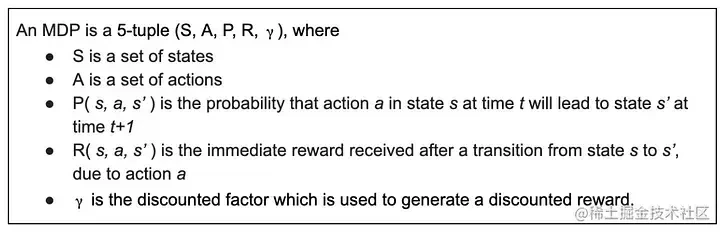

这是一个公式化的定义,如果你用谷歌搜索马尔可夫决策过程,你可能会得到这样的定义:

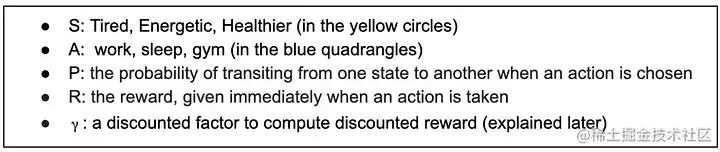

现在,让我们将这个框架应用到上面的图 2 中,以便更具体地理解这些抽象注释:

▶️ MDP 实战

我们可以通过一个故事使这一点更容易理解,以亚当为例。众所周知,这个努力工作的年轻人想尽可能多地赚钱。使用上面定义的框架,我们可以帮助他做到这一点。

▶️ 当 Adam 的状态为Tired时,他可以选择以下三个动作之一:(1) 继续工作,(2) 去健身房,(3) 睡会儿觉。

如果他选择工作,他将保持疲倦状态,并且有把握获得 +20 奖励。如果他选择睡觉,他有 80% 的几率进入下一个状态Energetic, **并有 20% 的几率保持Tired。

如果他不想睡觉,他可能会去健身房锻炼身体。这使他有 50% 的机会进入Energetic状态并有 50% 的机会保持Tired。然而,他需要支付健身房的费用,所以这个选择会导致 -10 的奖励。

▶️ 当 Adam 变得精力充沛时,他可以回去工作并且更有效率。从那里开始,他有 80% 的机会再次感到疲倦(获得 +40 奖励),并有 20% 的机会保持精力充沛(获得 +30 奖励)。

有时,当他精力充沛时,他想锻炼一下。在这种状态下锻炼,他过得很好,100%变得更健康。当然,他需要为此付出-10的奖励。

▶️ 到了Healthier的状态,他脑子里只有一件事:多干活多挣钱。因为状态这么好,他工作效率最高,获得+100的奖励,一直工作到累了为止。

有了以上信息,我们可以训练一个代理人,旨在帮助 Adam 找到**策略,以随着时间的推移最大化他的奖励。该代理人将进行马尔可夫决策过程。

然而,在我们这样做之前,我们需要知道如何计算在一种状态下采取行动时的累积奖励。也就是说,我们必须能够估计状态值。

不用担心!这只需要一分钟就可以完成。

折扣奖励

正如我们在RL 简介中了解到的,强化学习是一个多决策过程。与监督学习的“一个实例,一个预测”模型不同,强化学习代理的目标是最大化一系列决策的累积奖励——而不仅仅是一个决策的即时奖励。

它要求代理人在收集当前奖励的同时展望未来。

在上面亚当的例子中,未来的回报与当前的回报一样重要。但在我们这里讨论的CartPole 游戏中,活在当下比什么都重要。

因为未来的奖励可能会根据场景的不同而不同,我们需要一种机制来降低未来奖励在不同时间步长的重要性。

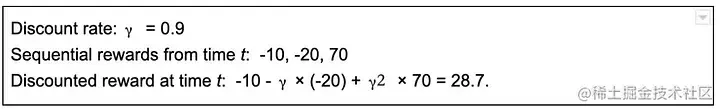

上面的贴现率或因子符号是该机制的关键。它计算出的奖励被称为折扣奖励。

考虑以上信息。如果贴现率接近于 0,则与即时奖励相比,未来奖励的意义不大。相比之下,如果贴现率接近 1,那么遥远未来的奖励几乎与即时奖励一样重要。

考虑以上信息。如果贴现率接近于 0,则与即时奖励相比,未来奖励的意义不大。相比之下,如果贴现率接近 1,那么遥远未来的奖励几乎与即时奖励一样重要。

简而言之,折扣奖励我们如何估计状态的价值。

概括

到目前为止,在我们的强化学习系列中,我们已经了解到:

- 强化学习是什么以及它在日常生活中的应用。

- Markov Property and Chain 如何工作以生成单词。

- 现在,我们知道如何使用 MDP 和折扣奖励。

借助 MDP,我们可以帮助 Adam 做出既保证收入最大化又不损害健康的决定。在现实世界中,您可以收集反映现实的数据,分析统计数据,并创建有效的 MDP 来解决各种问题!